Ob Anfänger:in oder erfahrene:r Unternehmer:in – wahrscheinlich hast du schon viele Artikel über A/B-Tests gelesen und testest vielleicht sogar E-Mail-Betreffzeilen oder Social-Media-Posts.

Trotzdem passieren in der Praxis oft Fehler, die zu ungenauen Ergebnissen und falschen Geschäftsentscheidungen führen. A/B-Tests werden häufig zu sehr vereinfacht dargestellt, besonders für Händler:innen. Hier findest du eine einfache und praxisnahe Einführung in verschiedene A/B-Test-Arten für den E-Commerce – wichtig für Produktpositionierung, Conversion-Optimierung und mehr.

Was ist A/B-Testing?

A/B-Testing, auch Split-Testing genannt, vergleicht zwei Versionen eines digitalen Elements, um herauszufinden, welche besser beim Nutzer ankommt. Es hilft, Marketingkampagnen zu optimieren, das Verhalten der Zielgruppe besser zu verstehen und mehr Umsatz aus bestehendem Traffic zu erzielen – alles auf Basis datengetriebener Entscheidungen.

Wie A/B-Tests funktionieren

- Definiere dein Ziel. Lege deine Ziele für den A/B-Test fest, z. B. die Erhöhung der Conversion-Rate, der Klickrate oder des Gesamtumsatzes.

- Wähle das zu testende Element. Du kannst Überschriften, Bilder, E-Mail-Betreffzeilen, Call-to-Actions (CTAs), Preise, Layouts usw. testen.

- Erstelle Variationen. Entwickle zwei Versionen des Elements: Version A, das ist die ursprüngliche Version deines Assets, oder die "Kontrolle". Version B, die neue Version mit den Änderungen, die du testen willst, wird als "Variante" bezeichnet. Im Rahmen des Marketings zeigst du 50% der Besucher:innen Version A und 50% der Besucher:innen Version B.

- Führe den Test durch. Setze beide Gruppen über einen bestimmten Zeitraum mit der gleichen Version ein. Wenn du z. B. den CTA-Button einer E-Commerce-Website testest, kannst du die Tests zwei Wochen lang durchführen, um statistisch signifikante Ergebnisse zu erzielen.

- Erfasse Daten. Überwache und messe Conversions, Klickraten, Engagement und Verkäufe in beiden Versionen.

- Analysiere die Ergebnisse. Vergleiche die Leistung von Version A mit der von Version B, um festzustellen, welche Version dein Ziel besser erreicht. Die Version mit der höchsten Conversion-Rate gewinnt.

- Lege die Erstplatzierung fest. Wenn Version B die höchste Conversion-Rate hat, erkläre sie zur Siegerin und schicke 100% der Besucher:innen dorthin. Dies wird deine neue Kontrollvariante für zukünftige Tests.

💡Hinweis: Die Conversion-Rate eines A/B-Tests ist oft ein unvollkommenes Maß für den Erfolg.

Wenn du z.B. auf einer Seite einen Artikel für 50 Euro anbietest, während er auf der anderen Seite völlig kostenlos ist, wird das keinen wirklich wertvollen Einblick geben. Wie bei jedem Instrument oder jeder Strategie, die du für dein Unternehmen einsetzt, muss es strategisch sein.

Deshalb solltest du den Wert einer Conversion bis hin zum endgültigen Verkauf verfolgen.

Wann du A/B-Tests durchführen solltest

Wenn du eine Website mit geringem Traffic oder eine Web- oder Mobil-App betreibst, sind A/B-Tests wahrscheinlich nicht die beste Optimierungsmaßnahme für dich. Einen höheren Return on Investment (ROI) erzielst du wahrscheinlich, wenn du Nutzertests durchführst oder mit deinen Kund:innen sprichst. Entgegen der landläufigen Meinung beginnt und endet die Optimierung der Conversion-Rate nicht mit dem Testen.

Warum zwei bis vier Wochen? Du solltest Tests mindestens über zwei volle Geschäftszyklen laufen lassen – in der Regel zwei bis vier Wochen. Längere Testphasen sind problematisch: Sie erhöhen das Risiko für verfälschte Ergebnisse, etwa durch Cookie-Löschungen oder Gerätewechsel.

Ein zu langer Test kann genauso unzuverlässig sein wie ein zu kurzer.

Tests lohnen sich nur, wenn die nötige Stichprobengröße innerhalb von zwei bis vier Wochen erreicht wird. Ansonsten sind andere Optimierungsansätze sinnvoller, bis mehr Traffic vorhanden ist.

Richte deinen A/B-Testprozess ein

Priorisiere A/B-Testideen

Eine lange Liste von Testideen ist oft überwältigend – Priorisierung hilft, den richtigen Startpunkt zu finden.

Drei gängige Frameworks:

- ICE: Bewertet Impact (Wirkung), Confidence (Zuversicht) und Ease (Einfachheit) jeweils von 1–10. So kannst du einschätzen, wie groß der Effekt ist, wie sicher du dir bist und wie leicht der Test umzusetzen ist. Da Bewertungen subjektiv sind, helfen klare Richtlinien für mehr Objektivität.

- PIE: Steht für Potential, Importance (Bedeutung) und Ease, ähnlich wie ICE, berücksichtigt aber etwa den Traffic-Anteil, den ein Test erreicht. Auch hier sind Richtlinien wichtig, um die Subjektivität zu reduzieren.

- PXL: Entwickelt vom CXL Institute, verwendet Ja/Nein-Fragen zu Testzielen (z. B. „Steigert der Test die Motivation?“) plus eine Bewertung zur Umsetzbarkeit. Dadurch wird die Priorisierung objektiver und flexibler.

Jetzt hast du eine Vorstellung, wie du anfangen kannst. Zudem kann dir das Ganze bei der Kategorisierung deiner Ideen helfen. Wir haben bei einer durchgeführten Konvertierungsrecherche drei Kategorien verwendet: Implementieren, Untersuchen und Testen.

- Umsetzen. Mach es einfach. Etwas funktioniert nicht oder ist offensichtlich.

- Untersuchen. Erfordert zusätzliche Überlegungen, um das Problem zu definieren oder eine Lösung einzugrenzen.

- Testen. Die Idee ist solide und datengestützt. Teste sie!

Mit dieser Kategorisierung und Priorisierung bist du bereit, mit A/B-Tests zu beginnen.

Wenn du noch auf der Suche nach Inspiration für deinen Shop bist, beschäftigen wir uns in diesem Blogbeitrag mit der Frage: "Was lässt sich gut verkaufen?"

Entwickle eine Hypothese

Bevor du etwas testest, musst du eine Hypothese aufstellen. Zum Beispiel: "Wenn ich den Versandpreis senke, wird die Conversion-Rate steigen.“

Keine Sorge - eine Hypothese zu bilden ist in dieser Situation nicht so kompliziert, wie es vielleicht klingt. Im Grunde musst du eine Hypothese testen, keine Idee. Eine Hypothese ist messbar, zielt auf die Lösung eines bestimmten Conversion-Problems ab und konzentriert sich auf Erkenntnisse und nicht auf Gewinne.

Wenn du eine Hypothese schreibst, ist es hilfreich, eine Formel aus Craig Sullivans Hypothesis Kit zu verwenden:

- Weil ich [Daten einfügen / Forschungsergebnisse] beobachtet habe

- erwarte ich, dass [getestete Veränderung] sich folgendermaßen auswirken wird: [Auswirkung, die du erwartest]

- Ich werde diesen anhand von [Datenkennzahl] messen

Ganz einfach, oder? Du musst nur noch die Lücken ausfüllen und schon hat sich deine A/B-Test-Idee in eine Hypothese verwandelt.

Wähle ein A/B-Testing-Tool

Beliebte Tools sind Google Optimize, Optimizely und VWO:

- Google Optimize: Kostenlos, mit Einschränkungen bei multivariaten Tests. Ideal für Einsteiger, da gut mit Google Analytics verknüpft.

- Optimizely: Einfach zu bedienen, auch ohne Tech-Know-how. Bietet gute Analysefunktionen, aber ist meist die teuerste Option.

- VWO: Intuitiver Editor und hilfreiche Zusatzfunktionen wie Heatmaps und Umfragen.

Auch im Shopify App Store findest du passende Tools.

Nach der Auswahl meldest du dich an, fügst meist ein Code-Snippet ein und legst Ziele fest – die genaue Umsetzung variiert je nach Tool.

Entscheide, wie du die Ergebnisse analysierst

Wenn du deine Hypothese richtig gestaltest, kann sogar ein Verlierer zum Gewinner werden. Denn so erhältst du Erkenntnisse, die du für zukünftige Tests und andere Geschäftsbereiche nutzen kannst. Wenn du also deine Testergebnisse analysierst, musst du dich auf die Erkenntnisse konzentrieren, und nicht darauf, ob der Test einen Gewinner oder Verlierer hervorgebracht hat. Es gibt immer etwas zu lernen und immer etwas zu analysieren. Ignoriere nicht die Verlierer!

Der wichtigste hierbei zu erwähnende Faktor ist die Notwendigkeit der Segmentierung. Ein Test mag insgesamt einen Verlierer hervorgebracht haben. Jedoch stehen die Chancen gut, dass der Test zumindest in einem Segment gute Ergebnisse generiert hat. Was genau ist mit Segmenten gemeint?

Hier sind einige Beispiele für Publikumssegmente:

- Neue Besucher:innen

- Wiederkehrende Besucher:innen

- iOS- Besucher:innen

- Android- Besucher:innen

- Chrome Besucher:innen

- Safari- Besucher:innen

- Desktop- Besucher:innen

- Tablet- Besucher:innen

- Besucher:innen der organischen Suche

- Bezahlte Besucher:innen

- Besucher:innen der sozialen Medien

- Eingeloggte Käufer:innen

Du verstehst, was ich meine, oder?

Die Chancen stehen gut, dass sich die Hypothese in bestimmten Segmenten als richtig erwiesen hat. Auch das sagt dir etwas.

Kurz und knapp: Bei der Analyse geht es um so viel mehr, als die Frage, ob der Test einen Gewinner oder Verlierer hervorgebracht hat. Konzentrier dich auf die Erkenntnisse und segmentiere deine Daten, um unter der Oberfläche verborgene Erkenntnisse zu gewinnen.

Tools für dein A/B-Testing werden die Analyse nicht für dich übernehmen. Von daher ist dies eine wichtige Fähigkeit, die im Laufe der Zeit entwickelt werden sollte.

Archiviere deine Testergebnisse

Wirst du dich in zwei Jahren noch an deinen ersten A/B-Test erinnern? Wahrscheinlich nicht – darum ist ein Archiv wichtig. Ohne Dokumentation gehen wertvolle Erkenntnisse verloren, und doppelte Tests passieren schneller als gedacht.

Ob du ein Tool wie Projects, Effective Experiments oder einfach Excel nutzt, ist dir überlassen. Wichtig ist, dass du Folgendes festhältst:

- Hypothese

- Screenshots von Kontroll- und Testversion

- Testergebnis (gewonnen/verloren)

- Zentrale Erkenntnisse

Ein gut gepflegtes Archiv hilft dir – und später auch deinem Team.

Beispiele für A/B-Tests

Technische Analyse

Lädt dein Shop auf jedem Browser richtig und schnell? Auf jedem Gerät? Du hast vielleicht ein glänzendes neues Smartphone, aber irgendwo ist immer noch ein Klapphandy aus dem Jahr 2005 im Einsatz. Wenn deine Website nicht richtig und schnell funktioniert, wird sie definitiv nicht so gut konvertieren, wie sie könnte.

On-site Befragungen

Diese Befragungen erscheinen, während deine Besucher:innen sich in deinem Shop umschauen. Eine solche On-site-Befragung könnte Besucher:innen fragen, ob sie etwas Bestimmtes davon abgehalten hat, ein Produkt in den Warenkorb zu legen. Wenn ja, was ist das genau? Du kannst solche qualitativen Daten nutzen, um deinen Text und deine Konvertierungsrate zu optimieren.

Kundengespräche

Nichts kann ein Ersatz dafür sein, ganz klassisch zum Telefonhörer zu greifen und mit deinen Kund:innen zu sprechen. Warum haben sie deinem Shop den Vorzug gegenüber der Konkurrenz gegeben? Welches Problem wollten sie lösen, als sie auf deiner Seite gelandet sind? Du kannst eine Million Fragen stellen, um zu ergründen, wer deine Kund:innen wirklich sind und warum sie tatsächlich von dir kaufen.

Kundenumfragen

Kundenumfragen sind umfangreiche Umfragen, die sich an Leute richten, die bereits bei dir eingekauft haben (statt lediglich Besucher:innen). Wenn du eine solche Umfrage konzipierst, solltest du dich auf Folgendes konzentrieren: Definition deiner Kund:innen; Definition ihres Problems; Definition von Bedenken, die sie vor dem Kauf hatten; Identifikation von Wörtern und Aussagen, mit denen sie deinen Shop beschreiben.

Auswertung deiner Analytik

Tracken und berichten deine Analytik-Tools deine Daten korrekt? Das mag sich vielleicht albern anhören, aber du wärst wahrscheinlich überrascht, wenn du wüsstest, wie viele Analytik-Tools tatsächlich falsch konfiguriert sind. Bei der Auswertung deiner Analytik geht es darum, tief in deine Zahlen einzusteigen und zu analysieren, wie sich deine Besucher:innen verhalten. Du kannst dich beispielsweise auf deinen Funnel konzentrieren. Wo ist er undicht? In anderen Worten: An welcher Stelle deines Funnels springen die meisten Leute ab? Dies ist ein guter Ort, um mit dem Testen zu beginnen.

User-Tests

Hierbei beobachtest du echte Menschen dabei, wie sie bestimmte Aufgaben auf deiner Seite ausführen. Du könntest beispielsweise darum bitten, ein Videospiel in der Preiskategorie 40–60 EUR zu finden und dieses ihrem Warenkorb hinzuzufügen. Während die ausgewählten Personen die Aufgabe ausführen, werden sie im Verlauf ihre Gedanken und Handlungen laut kommentieren.

Session Replays

Session Replays sind den User-Tests ähnlich. Jedoch geht es hierbei um echte Personen mit echtem Geld und einer echten Kaufabsicht. Du schaust dabei zu, wie deine tatsächlichen Besucher:innen sich durch deine Seite navigieren. Was fällt ihnen schwer zu finden? Wobei kommt Frustration auf? An welcher Stelle scheinen sie verwirrt zu sein.

Es gibt noch weitere Untersuchungsmethoden, diese sieben Ansätze sind jedoch bereits ein guter Ausgangspunkt. Wenn du einige davon nutzt und durchläufst, wirst du eine riesige Liste mit datenbasierten Ideen erhalten, die du im Anschluss testen kannst. Ich garantiere dir: Diese Liste bringt dir mehr als jeder Artikel à la “99 Dinge, die du jetzt testen solltest”.

A/B-Testverfahren der Profis

Nachdem du nun ein Standard-A/B-Testing-Tutorial durchlaufen hast, lass uns einen Blick auf die genauen Prozesse der Profis werfen.

Krista Seiden, KS Digital – Mein A/B-Testing-Prozess

Alles beginnt mit der Analyse: Nutze Analytics-, Umfrage- oder UX-Daten, um Optimierungspotenziale zu erkennen.

Darauf basierend entwickelst du Hypothesen, was verbessert werden kann – und setzt Tests auf. Diese sollten etwa zwei Wochen laufen, um Schwankungen im Nutzerverhalten abzudecken. Danach wertest du die Ergebnisse aus – auch von Varianten, die nicht gewonnen haben. Auch daraus lassen sich wertvolle Erkenntnisse gewinnen.

Wenn dein Testing-Programm gut etabliert ist, kannst du dich dem Thema Personalisierung widmen – etwa durch gezielte Inhalte oder individuelles Targeting. Starte aber erst damit, wenn die Grundlagen solide stehen.

Alex Birkett, HubSpot

Auf einem hohen Niveau versuche ich dem folgenden Prozess zu folgen:

- Daten sammeln und sicherstellen, dass die Analytics-Implementierungen korrekt sind.

- Daten analysieren und Erkenntnisse gewinnen.

- Erkenntnisse in Hypothesen verwandeln.

- Priorisierung basierend auf Auswirkung und Einfachheit und die Verteilung meiner Ressourcen maximieren (vor allem technische Ressourcen).

- Test durchführen (unter Befolgung bewährter statistischer Verfahren nach bestem Wissen)

- Ergebnisse analysieren und auf deren Basis implementieren (oder nicht).

- Anpassen auf Basis der Ergebnisse und wiederholen.

Einfacher ausgedrückt: Recherchieren, Testen, Analysieren, Wiederholen.

Während dieser Prozess in Abhängigkeit des Kontexts abweichen oder sich ändern kann (Teste ich ein geschäftskritisches Produktmerkmal? Einen CTA eines Blog-Beitrags? Wie stellt sich das Risikoprofil und die Balance zwischen Innovation und Risikominimierung dar?), ist er für Unternehmen fast jeder Art und Größe geeignet.

Der Punkt ist, dass dieser Prozess sehr agil ist und gleichzeitig genügend Daten sammelt, sowohl qualitatives Kundenfeedback als auch quantitative Daten. Anschließend können auf dieser Basis bessere Testkonzepte entwickelt und entsprechend priorisiert werden, um keinen Traffic zu verschwenden.

Ton Wesseling, Online-Dialog

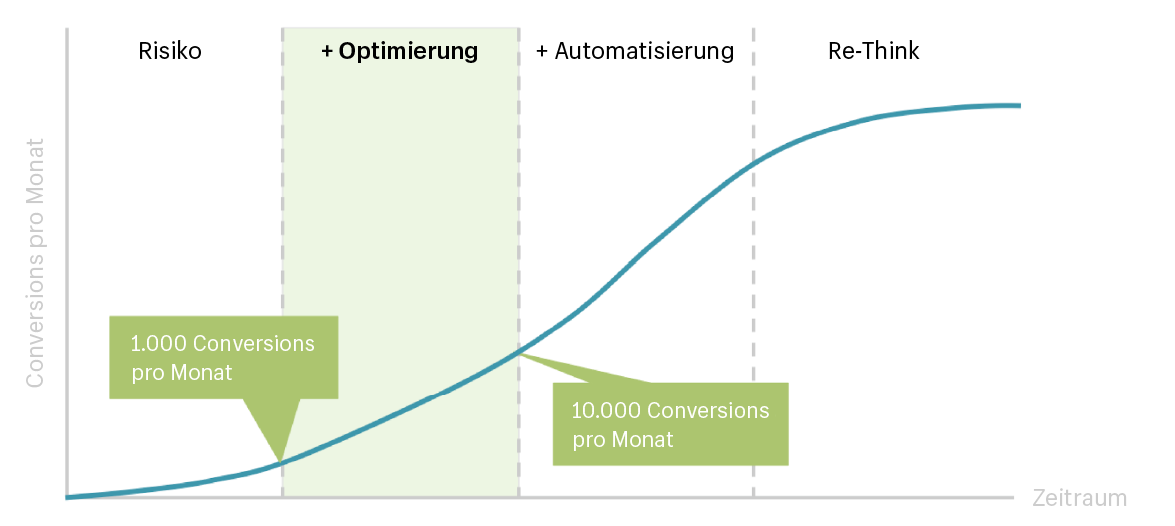

Die erste Frage, die wir mit Blick auf die Optimierung einer Customer Journey beantworten, lautet: Wohin passt dieses Produkt oder diese Dienstleistung im ROAR-Modell, das wir hier bei Online Dialogue entwickelt haben? Befindest du dich noch immer in der Risikophase, in der wir zwar viel Forschung betreiben könnten, unsere Ergebnisse jedoch nicht durch Online-Experimente validieren können (unter 1.000 Konvertierungen pro Monat)? Oder steckst du bereits mitten in der Optimierungsphase? Oder bist sogar schon einen Schritt weiter?

- Risikophase: Eine Menge Forschung, auf deren Basis sich dann Dinge wie ein neuer Angelpunkt des bestehenden Geschäftsmodells bis hin zu einem komplett neuen Design und Leistungsversprechen entwickeln lassen.

- Optimierungsphase: Groß angelegte Experimente, die das Leistungsversprechen und das Geschäftsmodell optimieren werden.

- Optimierungsphase: Kleinere Experimente, um Hypothesen zum Benutzerverhalten zu validieren, aus denen sich letztendlich Erkenntnisse für umfangreichere Designanpassungen ergeben können.

- Automatisierung: Du hast immer noch genügend Ressourcen (Besucher:innen) übrig, was bedeutet, dass für die Validierung deiner User Journey nicht dein gesamtes Test-Potenzial benötigt wird. Was davon übrig bleibt, sollte für ein schnelleres Wachstum eingesetzt werden (mit Fokus auf langfristigen Erkenntnissen). Dies kann durch Ausführen von entsprechenden Algorithmen automatisiert werden.

- Re-think (Überdenken): Du beendest das Hinzufügen weiterer Forschungsbemühungen, es sei denn, es weist den Weg zu etwas Neuem.

Vor diesem Hintergrund sind A/B-Tests nur in der Optimierungsphase des ROAR-Modells und darüber hinaus (bis zum Überdenken) eine große Sache.

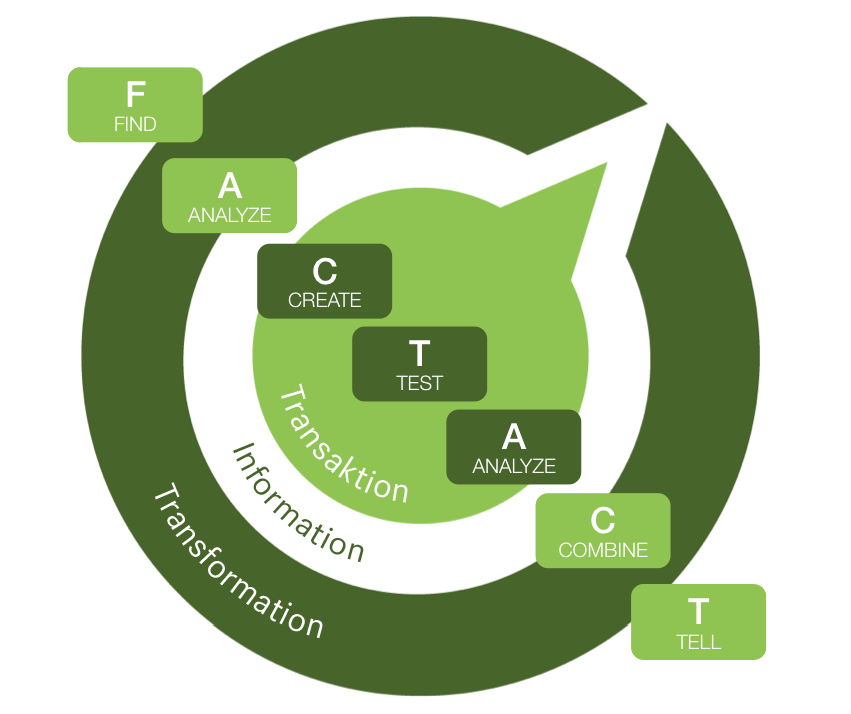

Unser Ansatz für die Durchführung von Experimenten ist das FACT & ACT-Modell:

- Find (ein Problem finden): Vor einem Experiment muss immer das zu klärende Problem festgestellt werden.

- Analyze (das Problem analysieren): Wie das bestehende Problem entstanden ist und warum es existiert, muss analysiert werden.

- Create (eine Hypothese kreieren): Um das Problem zu Lösen, muss eine experimentelle Hypothese erstellt werden.

- Test (die Hypothese testen): Nun sollte die Hypothese zur Problemlösung getestet werden.

- Analyze (den Test auswerten): Hinsichtlich der Verbesserung des Problems, sollten die Testergebnisse analysiert werden.

- Combine (die Ergebnisse zu einem Lösungsansatz kombinieren): Aus der Analyse der Ergebnisse kann nun ein Lösungsansatz kombiniert werden.

- Tell (deine Ergebnisse teilen): Deinen Lösungsansatz kannst du nun in deinem Unternehmen teilen, um das Problem lösen zu können.

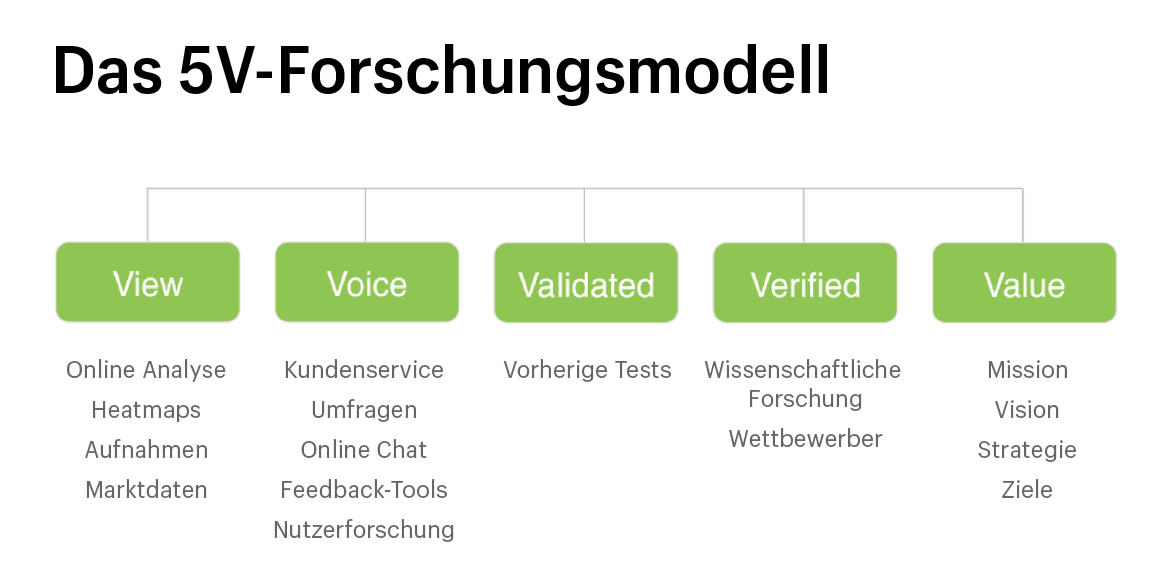

Die von uns vorgenommene Forschungsleistung basiert auf unserem 5V-Modell.

- View: Überblick gewinnen durch Marktdaten oder Online-Analyse.

- Voice: Kundenstimmen mit Umfragen, Chats oder Feedback-Tools einholen.

- Validated: Eigene Ergebnisse mit bestehenden Studien vergleichen.

- Verified: Wissenschaftlich belegte Infos als Grundlage nutzen.

- Value: Forschungsergebnisse sollen einen klaren Nutzen und Ziele liefern.

Wir sammeln all diese Erkenntnisse, um eine forschungsgestützte Haupthypothese aufzustellen, die zu Unterhypothesen führt, die auf der Grundlage der durch A/B-Tests für Desktop- oder Mobilgeräte gesammelten Daten priorisiert werden. Je höher die Wahrscheinlichkeit ist, dass die Hypothese zutrifft, desto höher wird sie eingestuft.

Sobald wir wissen, ob unsere Hypothese richtig oder falsch ist, können wir damit beginnen, die Erkenntnisse zu kombinieren und größere Schritte zu unternehmen, indem wir größere Teile der Customer Journey umgestalten/neu ausrichten. Irgendwann führen jedoch alle erfolgreichen Umsetzungen zu einem lokalen Maximum. Dann musst du einen größeren Schritt machen, um ein potenzielles globales Maximum zu erreichen.

Und natürlich werden die wichtigsten Erkenntnisse im gesamten Unternehmen verbreitet, was zu allen möglichen weitergehenden Optimierungen und Innovationen auf der Grundlage deiner validierten Erkenntnisse aus erster Hand führt.

Julia Starostenko, Pinterest

Experimente prüfen, ob Änderungen auf der Webseite positive Auswirkungen haben.

Vor dem Start solltest du entscheiden, ob ein Experiment nötig ist. Zum Beispiel: Hat eine Schaltfläche eine sehr niedrige Klickrate, ist eine Verschlechterung unwahrscheinlich – ein Experiment lohnt sich hier oft nicht. Kleine Änderungen müssen nicht immer getestet werden, sondern können direkt ausgerollt und überwacht werden.

Wenn ein Experiment sinnvoll ist, legst du die Geschäftskennzahlen fest (z. B. Conversion-Rate) und sicherst die Datenerfassung. Dann wird die Zielgruppe zufällig in zwei Gruppen geteilt: eine sieht die alte, die andere die neue Variante. Die Conversion-Rate wird verglichen, und nach Erreichen der statistischen Signifikanz wertest du die Ergebnisse aus.

Peep Laja, CXL Institute

A/B-Tests sind nur 20 % des Erfolgs – 80 % stecken in der Forschung.

Mein Prozess:

- Nutze Frameworks wie ResearchXL, um Probleme auf der Website zu finden.

- Wähle ein wichtiges Problem mit großer Reichweite und sammle Lösungsansätze basierend auf der Forschung. Entscheide, ob Desktop oder Mobile getestet wird.

- Bestimme die Anzahl der Varianten basierend auf Traffic und wähle 1–2 Ideen für den Test.

- Erstelle eine Testmatrix mit allen Änderungen (Text, Design etc.). Hol ggf. einen Designer dazu.

- Lass die Änderungen vom Entwickler ins Test-Tool einbauen, richte Integrationen und Ziele ein.

- Prüfe den Test auf Funktion in allen Browsern und Geräten.

- Starte den Test und analysiere danach die Ergebnisse.

- Implementiere den Gewinner, optimiere weiter oder starte neue Tests.

Häufige Fehler bei A/B-Tests

Zu viele Variablen gleichzeitig testen

Wenn du zwei Variablen auf einmal vergleichst, kannst du möglicherweise nicht feststellen, welche Veränderung den Effekt verursacht hat.

Angenommen, du willst eine Landingpage optimieren. Anstatt nur eine Überschrift zu testen, testest du:

- Call-to-Action-Text

- Farbe der CTA-Schaltfläche

- Header-Bilder

- Überschriften

Die Conversion-Rates steigen, aber du kannst nicht genau sagen, welche Änderung dafür verantwortlich ist. Wenn du eine Variable nach der anderen testest, kannst du die Auswirkungen der einzelnen Änderungen isolieren und genauere Ergebnisse erhalten.

💡Hinweis: Multivariate Tests sind eine Option, wenn du verstehen willst, wie mehrere Variablen miteinander interagieren. Aber um einen multivariaten Test durchzuführen, brauchst du mehr Besucher:innen und eine bereits gut optimierte Seite, auf der du schrittweise Verbesserungen vornehmen kannst. Das Verfahren ist viel komplexer als ein A/B-Test.

Unzureichende Stichprobengröße

Die Zuverlässigkeit deiner A/B-Test-Ergebnisse hängt von der Größe der verwendeten Stichprobe ab. Kleine Stichproben können zu falsch positiven und negativen Ergebnissen führen, sodass es schwierig ist, festzustellen, ob die Unterschiede auf deine Änderungen oder den Zufall zurückzuführen sind.

Stell dir vor, du testest zwei Versionen einer Produktseite, um herauszufinden, welche Version zu höheren Kaufraten führt. Du teilst den Traffic auf, hast aber am Ende nur 100 Besucher:innen für Version A und 100 Besucher:innen für Version B.

Wenn Version A eine Conversion-Rate von 6 % und Version B eine Conversion-Rate von 5 % hat, denkst du vielleicht, dass Version A besser ist. Aber mit nur 100 Besucher:innen pro Version ist das statistisch nicht signifikant. Es ist möglich, dass die Ergebnisse anders ausgefallen wären, wenn du mit mehr Besuchenden getestet hättest.

Der beste Weg, um eine gesunde Stichprobengröße zu bestimmen, ist ein Stichprobenrechner.

Kurze Testdauer

Führe deinen A/B-Test mindestens einen, idealerweise zwei volle Geschäftszyklen lang durch. Breche deinen Test nicht ab, nur weil du die Signifikanz erreicht hast. Außerdem musst du die vorgegebene Stichprobengröße einhalten. Und vergiss nicht, alle Tests in Schritten von einer ganzen Woche durchzuführen.

Warum zwei vollständige Konjunkturzyklen? Zunächst einmal helfen dir zwei Zyklen dabei, alles zu berücksichtigen:

- "Ich muss darüber nachdenken" Käufer:innen.

- Verschiedene Traffic-Quellen (Facebook, E-Mail-Newsletter, organische Suche etc.)

- Anomalien. Zum Beispiel dein E-Mail-Newsletter vom Freitag.

Zwei Geschäftszyklen sind in der Regel genug Zeit, um wertvolle Erkenntnisse über das Nutzerverhalten deiner Zielgruppe zu gewinnen.

Wenn du schon einmal ein A/B-Test-Tool für Landingpages verwendet hast, kennst du wahrscheinlich das kleine grüne Symbol "Statistisch signifikant".

Für viele ist das leider das allgemeingültige Zeichen für "der Test ist gelaufen, beende ihn". Wie du weiter unten erfährst, bedeutet das nicht, dass du den Test abbrechen solltest, nur weil die statistische Signifikanz eines A/B-Tests erreicht wurde.

Nutzersegmentierung übersehen

Wenn du die verschiedenen Nutzersegmente nicht berücksichtigst, erhältst du verallgemeinerte Ergebnisse, die vielleicht nicht auf alle zutreffen.

Es ist hilfreich, die Nutzer:innen nach demografischen Merkmalen, Verhalten oder anderen relevanten Faktoren zu segmentieren. Was für neue Nutzer:innen funktioniert, muss nicht unbedingt auch für wiederkehrende Nutzer:innen gelten. Wenn du nicht segmentierst, wirst du wichtige Nutzergruppen verprellen und die Integrität deines Tests gefährden.

Optimiere A/B-Tests für dein Unternehmen

Du hast den Prozess und damit die Macht! Also leg los und teste deinen Shop. Ehe du dich versiehst, werden diese Erkenntnisse zu einem deutlichen Plus auf deinem Bankkonto führen.

In diesem Video (auf Englisch) erfährst du noch mehr zum Thema A/B-Testing und wie du richtig Meta Ads anlegst.

Dieser Beitrag erschien ursprünglich im Shopify.com-Blog und wurde übersetzt.

Weiterlesen

- Landing-Page- 10 Tipps zur Gestaltung und Leadgenerierung

- Produkte fotografieren- Ultimativer Leitfaden für schöne Produktfotos

- Produktbeschaffung- 13 Apps um Dropshipping-Produkte zu finden

- Kunst online verkaufen- Der ultimative Leitfaden, um deine Kunst zu verkaufen

- Dropshipping Steuern- Darauf solltest du achten!

- Wie du B2B-Shops mit Shopify umsetzt & deinen B2B-Onlineshop meisterst

- Werbetexte schreiben- So vermeidest du die 6 häufigsten Fehler und machst mehr Umsatz

- Cannabis-Produkte online verkaufen- Die Sanity Group gewinnt Snoop Dogg als Investor für Hanfgeschäft

- Retention Marketing- So verkaufst du mehr an bestehende Kunden - dank besserer Kundenbindung

- Verpackungen als Marketingwaffe- So bindest du Kunden nachhaltig an dein Unternehmen